オフライン利用できるOpenAI gpt-ossに入門!概要を学んで使ってみよう

はじめに

2025年8月、OpenAIが初めてのオープンウェイトモデル「gpt-oss」をリリースしました。これまでGPT-3やGPT-4はAPI経由でのみ利用可能でしたが、gpt-ossはApache 2.0ライセンスの下で完全にオープンソース化され、誰でも自由にダウンロードして利用できるようになりました。

特に注目すべきは、gpt-oss-20bが16GBのメモリで動作することです。これにより、一般的なPCでも本格的な生成AIを無料・無制限で利用できる時代が到来しました。本記事では、Ollamaを使ってgpt-ossを簡単にセットアップし、実際に使ってみた体験をお伝えします。

gpt-ossの主要な特徴

1. オープンライセンスで商用利用も可能

gpt-ossはApache 2.0ライセンスで提供されており、個人利用はもちろん、商用プロジェクトでも自由に利用できます。これまでのOpenAIモデルのようなAPI料金を気にする必要がなく、完全に無料で無制限に使用できます。企業でも安心して導入できる点が大きなメリットです。

2. 効率的なMixture-of-Expertsアーキテクチャ

gpt-ossは最新のMixture-of-Experts(MoE)技術を採用しています。gpt-oss-20bは総パラメータ数21億に対し、実際に動作するアクティブパラメータは3.6億程度です。gpt-oss-120bも117億の総パラメータに対し5.1億のアクティブパラメータで動作します。この仕組みにより、大規模モデルでありながら軽快な動作を実現しています。

3. 調整可能な推論能力

gpt-ossの特徴的な機能として、推論レベルを「low」「medium」「high」の3段階で調整できる点があります。簡単な質問には低レベルで高速応答し、複雑な問題には高レベルで詳細な思考プロセスを展開します。また、chain-of-thought(思考の連鎖)機能により、AIがどのように考えて答えに到達したかを確認することも可能です。

必要なシステム要件と準備

gpt-ossを動作させるために必要な環境は以下の通りです:

gpt-oss-20b(推奨)

- メモリ:16GB以上

- ストレージ:約15GB以上の空き容量

- OS:Windows、macOS、Linux

gpt-oss-120b

- GPU:80GB以上のVRAM(NVIDIA H100など)

- 一般的なPCでは動作困難

本記事では、より多くの方が試せるgpt-oss-20bを中心に解説します。16GBメモリのPCであれば、性能次第で十分動作可能です。

Ollamaを使ったインストール手順

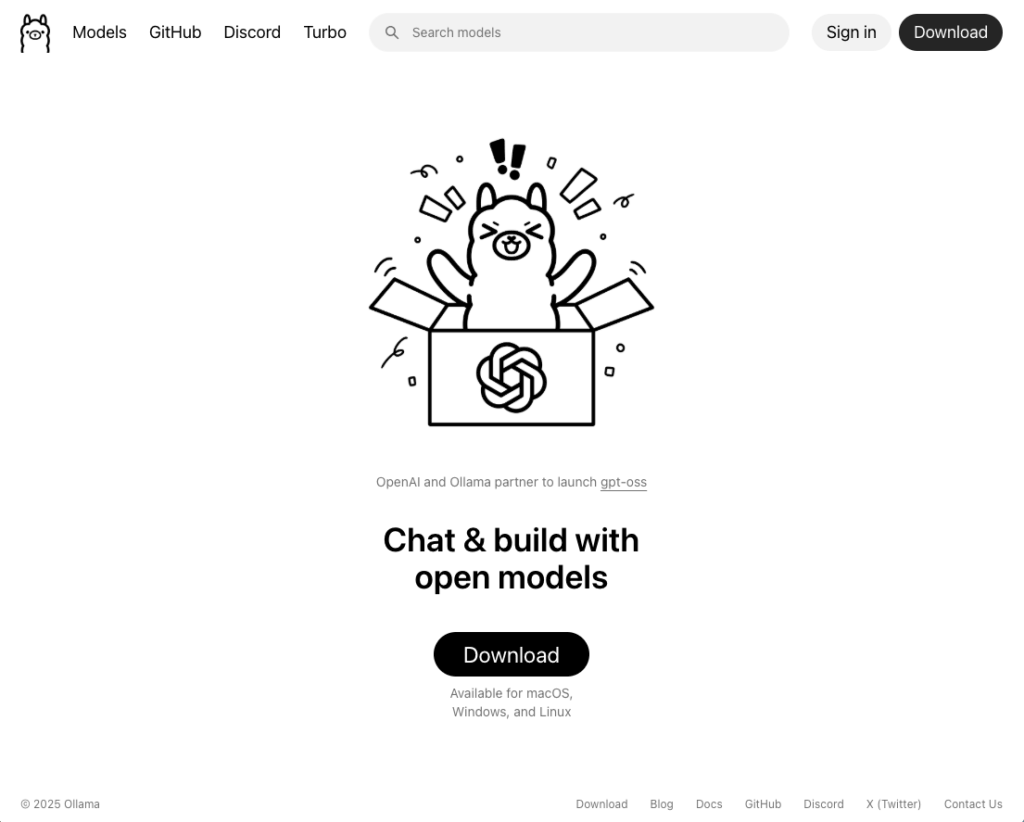

Ollamaとは

Ollamaは、ローカル環境でオープンソースの大規模言語モデルを簡単に実行できるツールです。コマンドライン操作に不慣れな方でも、直感的なGUIでモデルのダウンロードから実行まで行えます。Docker風のシンプルなコマンドでさまざまなモデルを管理できる点が特徴です。

インストール手順

- Ollamaのダウンロード ollama.comにアクセスし、お使いのOSに対応したOllamaアプリをダウンロードします。

- アプリケーションの起動 ダウンロード後、インストールを完了させてOllamaを起動します。初回起動時は、シンプルなチャット画面が表示されます。

- gpt-ossモデルの選択 チャット画面右下にあるモデル選択メニューから「gpt-oss:20b」を選択します(デフォルトで選択されている場合もあります)。

- 初回チャットでモデルダウンロード 「hello」など簡単な文言でチャットを開始します。この時点で「gpt-oss:20b」の自動ダウンロードが開始されるので、完了まで待機します。2025年9月時点では約13GBのダウンロードが必要でした。

- 利用開始 ダウンロード完了後、ChatGPTのWeb版のような感覚でやり取りができるようになります。

ターミナル版の利用方法

コマンドライン操作に慣れている方は、以下のコマンドでも起動できます:

bash

ollama run gpt-oss:20bこのコマンドでモデルのインストールと起動が同時に行われ、ターミナル上で直接チャットできます。

実際の使用感レビュー

応答品質について

gpt-oss-20bを実際に使用した印象として、一般的な質問応答や文章生成において非常に高い品質を示しました。OpenAIの公式ベンチマークでは、gpt-oss-20bがo3-miniと同等の性能を発揮するとされており、実際の使用感もそれを裏付けています。

特に、STEM分野(科学、技術、工学、数学)やプログラミング関連の質問に対しては、非常に詳細で正確な回答を提供します。コード生成においても、適切な構文と論理的な実装を提案してくれます。

パフォーマンスについて

16GBメモリのPCでの動作は、やはり重さを感じる場面もありました。特に長い文章の生成や複雑な推論を要する質問では、応答に時間がかかることがあります。純粋な処理速度ではAPIを経由するクラウドモデルの方が高速ですが、ローカル実行ではネットワーク遅延が発生しないため、短い応答では体感速度にそれほど差を感じない場合もあります。

メモリ使用量は起動時で約13GB程度となり、16GBメモリのPCではやや余裕が少ない状況です。バックグラウンドで他のアプリケーションを多数起動している場合は、事前に不要なプログラムを終了させることをお勧めします。

他のオープンモデルとの比較

Ollamaでは、gpt-oss以外にも多数のオープンソースモデルが利用可能です:

Gemma(Google製):軽量で高速動作が特徴。日常的な会話や簡単なタスクに適しています。

Qwen(Alibaba製):中国語に強く、多言語対応が優秀。アジア圏の言語処理に有効です。

DeepSeek:数学的推論に特化しており、複雑な計算問題の解決に長けています。

これらと比較すると、gpt-ossは推論能力に優れていますが、16GBメモリが必要という制約があります。一方でGemmaはより少ないメモリでも動作するため、8GBや12GBしかないPCでも利用可能です。お使いのPC環境やタスクの性質に応じて、複数のモデルを試してみることをお勧めします。まずは軽量なGemmaから始めて、より高度な推論が必要な場合にgpt-ossに切り替える、といった使い分けが効果的でしょう。

ビジネス活用の可能性

オフライン環境での利用価値

gpt-ossの最大の魅力は、完全にオフラインで動作することです。飛行機内や山間部など、インターネット接続が不安定な環境でも利用可能です。また、機密情報を扱う企業においても、データを外部に送信することなくAIを活用できる点は大きなメリットといえます。

プライバシーとコスト面でのメリット

API型のサービスでは、入力内容がサーバーに送信されるため、プライバシーの懸念がありました。gpt-ossなら全ての処理がローカルで完結するため、機密文書の要約や社内資料の分析も安心して行えます。

また、API利用料を気にすることなく、大量のテキスト処理や試行錯誤的な開発が可能になります。長期的に見れば、大幅なコスト削減効果が期待できるでしょう。

具体的な活用シーン

- オフライン文書作成支援:出張先でプレゼン資料の作成や文章校正

- プライベートカスタマーサポート:社内FAQシステムの構築

- 開発環境での活用:コードレビューや技術文書の生成

- 教育現場での利用:学習支援ツールとしての活用

注意点とトラブルシューティング

Harmony Response Formatの必要性

gpt-ossは「Harmony Response Format」という特殊な形式で訓練されているため、この形式以外では正常に動作しません。OllamaやHugging Face Transformers、vLLMなどの推奨ツールを使用する場合、フォーマットは自動的に適用されます。また、PythonのOpenAI SDKやOllama Python clientなどのライブラリ経由でアクセスする場合も、内部でフォーマットが適切に処理されるため、通常の使用では問題になることはほとんどありません。注意が必要なのは、低レベルのモデル推論を直接実装する場合のみです。

よくある問題と解決法

メモリ不足エラー:16GB未満のメモリでは動作しない可能性があります。他のアプリケーションを終了して再試行してください。

ダウンロードの中断:大容量ファイルのため、ネットワーク接続が不安定だとダウンロードが失敗することがあります。安定した回線での再実行をお勧めします。

応答が遅い:CPUやメモリのスペックが不足している場合、応答が著しく遅くなることがあります。推論レベルを「low」に設定することで改善される場合があります。

まとめと今後の展望

OpenAI初のオープンウェイトモデルgpt-ossは、生成AI利用の民主化において重要な意味を持ちます。16GBメモリのPCでも動作するgpt-oss-20bにより、個人開発者から企業まで、幅広い層が高品質な生成AIを活用できるようになりました。

オフライン利用、プライバシー保護、コスト削減という3つの大きなメリットにより、これまでAPI利用をためらっていた分野でも積極的なAI導入が進むと予想されます。

今回のような爆発的に進化している時期には、新しい技術を積極的に試し、知識と経験を蓄積することが重要です。次世代のAI活用方法を模索し、新たなビジネス機会の発見につなげていきましょう。ぜひ皆さんも実際にインストールして、オフライン生成AIの可能性を体験してみてください!