Docker ComposeでDifyを構築:手順と注意点まとめ

はじめに

最近話題のLLMアプリケーション開発プラットフォーム「Dify」をローカル環境で構築してみました。想像していたよりもずっと簡単で、5分程度で起動できてしまいました。この記事では、実際の構築手順から簡単なチャットアプリの作成まで、一連の流れをご紹介します。

Difyとは?

概要

Difyは、大規模言語モデル(LLM)を活用したアプリケーションを簡単に構築できるオープンソースプラットフォームです。ノーコード/ローコードでChatGPTのようなチャットボットや複雑なワークフローを直感的に作成できます。

主な特徴

マルチLLM対応 OpenAI(GPT-5、GPT-4、o3シリーズ)、Claude、Gemini、Llama2などの主要な商用・オープンソースモデルを統一インターフェースで利用できます。ローカルにデプロイしたLLMにも対応しており、プロジェクトの要件やコスト、プライバシー要件に応じて最適なモデルを選択可能です。

RAG(検索拡張生成)機能 Difyの最大の特長の一つが、内蔵された「ナレッジ」機能です。PDFやWordファイルをドラッグ&ドロップでアップロードするだけで、Difyが自動的にテキストを抽出し、ベクトル化(埋め込み)を実行します。このベクトルデータベースにより、質問に関連する情報を高精度で検索し、そのコンテキストを使ってLLMが回答を生成する仕組みが構築されます。企業の社内文書、技術マニュアル、FAQ等を「学習」した専門性の高いAIアシスタントを、プログラミング知識なしで簡単に作成可能です。

直感的なワークフロー構築 ドラッグ&ドロップの視覚的なインターフェースで複雑なAIワークフローを設計できます。条件分岐、データ変換、複数のLLMの組み合わせなど、プログラミング知識なしでも高度な処理フローを構築可能。まさに「AIのワークフローをレゴブロックのように組み立てる」感覚です。

強力なAPI提供機能 作成したアプリケーションを即座にREST APIとして公開できます。既存のWebサイト、モバイルアプリ、社内システムとの統合が容易で、AI機能を既存インフラに素早く組み込めます。Webhook機能も充実しており、リアルタイムな連携も可能です。

柔軟なチーム管理システム オーナー、管理者、エディター、メンバーの4段階の権限レベルでチーム協業を効率化します。プロジェクトごとの適切な権限設定により、セキュリティを保ちながらスムーズな共同作業を実現。ただし、セルフホスト版では単一ワークスペースのみの制限があります。

SaaS版との違い

- ローカル版: 完全無料(Apache 2.0ベースライセンス)、データ管理の自由度が高い

- SaaS版: セットアップ不要、メンテナンス不要、有料プランあり

注意点: この記事は2025年9月時点の内容です。最新情報は「最新情報を調べて、Difyのローカル環境構築を教えて」とChatGPTなどにお聞きください。

環境構築手順

前提条件

- Docker Desktop がインストール済み(Windows/Mac対応)

- Git がインストール済み

- メモリ: 8GB以上推奨(複数コンテナが起動するため)

システム要件詳細

- CPU:2コア以上

- メモリ:4GB以上(8GB推奨)

- ストレージ:20GB以上の空き容量

- Docker Desktop:対応OS(Windows、macOS、Linux)

詳細手順

1. リポジトリをクローン

git clone https://github.com/langgenius/dify.git

cd dify

2. 環境設定ファイルの確認

# dockerディレクトリに移動

cd docker

# .env.exampleをコピー(必要に応じて編集)

cp .env.example .env

3. Docker Composeで起動

# バックグラウンドで起動する場合

docker compose up -d

# ログを確認しながら起動する場合

docker compose up

4. 起動確認とトラブルシューティング

- 起動には3-5分程度かかります

docker psでコンテナの状態を確認- エラーが発生した場合は

docker compose logsでログを確認

5. 初期アクセス

- ブラウザで

http://localhostにアクセス - 初回アクセス時にアカウント作成画面が表示されます

- 管理者アカウントを作成してログイン

よくあるトラブルと解決方法

- ポート競合: 80番ポートが使用中の場合は

.envファイルでポート変更 - メモリ不足: Docker Desktopのメモリ割り当てを8GB以上に設定

- 起動が遅い: 初回は各種イメージのダウンロードで時間がかかる場合があります

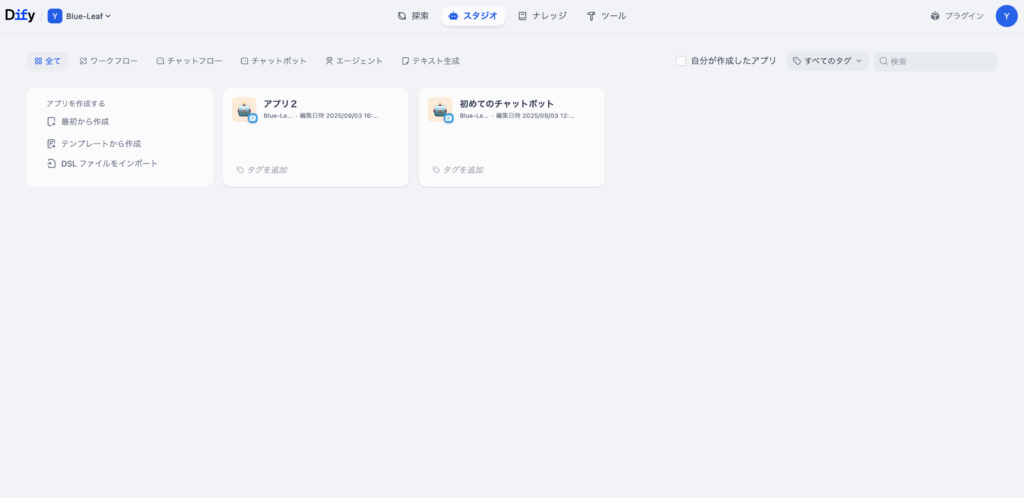

チャットアプリを作ってみる

アプリケーション作成の流れ

1. 新しいアプリケーションの作成

- ダッシュボードで「アプリを作成」をクリック

- 「最初から作成」を選択

- アプリタイプで「チャットフロー」を選択

- アプリ名と説明を入力

2. LLMの設定

- フロー定義画面でLLMノードをクリック

- モデルプロバイダーを選択(OpenAI、Claude、Gemini等)

- APIキーを設定

- 使用するモデルを選択(gpt-4、gpt-3.5-turbo等)

- システムプロンプトを設定(オプション)

3. プロンプトのカスタマイズ

あなたは親切で知識豊富なAIアシスタントです。

ユーザーの質問に対して、正確で分かりやすい回答を提供してください。

4. アプリの公開と共有

- 右上の「公開」ボタンをクリック

- 公開設定を確認

- WebアプリのURLが生成される

- QRコードやリンクで共有可能

実際に使ってみた感想

作成したチャットアプリは、まさにChatGPTのようなインターフェースで動作します。レスポンスも速く、カスタマイズした通りの動作を確認できました。

応用例とユースケース

1. カスタマーサポートボット

企業のFAQやマニュアルを学習させることで、顧客からの問い合わせに24時間自動対応できるチャットボットを構築できます。さらに、既存の社内システム(CRM、チケット管理システム等)との連携により、解決できない問い合わせを自動的にサポートチケットとして作成し、担当部門に振り分ける仕組みも実現可能です。

2. 文書要約ツール

PDFやWordファイルをアップロードするだけで、重要なポイントを抽出して要約するシステムを作成できます。複数の文書を同時に処理して比較分析を行ったり、異なる観点から内容を整理したりする機能も実装可能で、情報収集や意思決定の効率化に大きく貢献します。

3. コード生成アシスタント

特定のプログラミング言語や開発フレームワークに特化したコード生成ツールを構築できます。要件を自然言語で入力すると適切なコードを生成するだけでなく、既存コードのレビューや改善提案、バグの検出とfix案の提示など、開発チーム全体の生産性向上をサポートする包括的なアシスタントの実現が可能です。

ローカル環境のメリット・デメリット

メリット

- コスト: 完全無料(APIキー代のみ)

- プライバシー: データが外部に送信されない

- カスタマイズ性: 自由度が高い設定変更

- 学習目的: システム構成を理解できる

デメリット

- 保守性: アップデートやメンテナンスが必要

- リソース消費: ローカル環境のリソースを使用

- 可用性: 自前での稼働率管理が必要

まとめ

構築の簡単さ

Docker環境があれば、わずか数コマンドでDifyを起動できました。想像していたよりもはるかに簡単で、セットアップに詰まることはありませんでした。

今後の展開

RAG機能を活用したナレッジベース構築 社内に散在するマニュアル、議事録、技術文書、FAQ等を統合したインテリジェントな社内検索システムの構築を検討しています。例えば「新入社員向けの質問応答ボット」や「技術的なトラブルシューティングアシスタント」など、部門ごとの専門知識を活用したAIアシスタントを段階的に導入していく予定です。PDF、Word、Excel等の既存ドキュメントをそのまま活用できるため、データ整備の手間も最小限に抑えられます。

業務プロセス自動化のワークフロー設計 複雑な業務フローをDifyのワークフロー機能で自動化することで、大幅な効率化を図りたいと考えています。具体的には、お問い合わせの自動分類・振り分けシステム、レポート生成の自動化、多言語対応の翻訳ワークフローなどを想定しています。条件分岐や並列処理、外部サービス連携を組み合わせることで、従来は人手に頼っていた定型業務を大幅に削減できる可能性があります。

既存システムとのシームレス連携 DifyのAPI機能を活用して、現在利用している業務システム(CRM、チャットツール、プロジェクト管理ツールなど)との統合を進める予定です。SlackやTeams上で直接AIアシスタントを呼び出したり、Webhookを使ってリアルタイムでデータ連携したりすることで、ユーザーが新しいツールを覚える負担なく、AI機能を既存の業務フローに自然に組み込めます。また、社内システムのデータベースと連携することで、よりコンテキストに応じた精度の高いAI応答が期待できます。

選択肢について

Dockerでの構築が難しい場合は、公式のSaaS版も利用可能です。まずはSaaS版で機能を試してから、本格運用時にローカル環境を検討するのも良いアプローチだと思います。

Difyは本当に可能性に満ちたツールです。LLMアプリケーション開発の民主化を実感できました。今後も様々な用途で活用を検討してみたいと思います!